AI - cơ hội hay mối đe dọa với loài người?

Siết chặt quản lý vì rủi ro nhân loại

Tháng 5 năm nay, hàng trăm nhân vật hàng đầu về AI đã đưa ra một tuyên bố chung mô tả mối đe dọa hiện hữu của công nghệ mà họ đang tạo ra đối với nhân loại. Tuyên bố nêu rõ: “Việc giảm thiểu nguy cơ diệt vong bởi AI phải là ưu tiên toàn cầu, tương đương các rủi ro quy mô xã hội khác như đại dịch và chiến tranh hạt nhân”.

Lời thừa nhận hiếm hoi đã được ký bởi hàng trăm giám đốc điều hành và nhà khoa học từ các công ty hàng đầu về AI, bao gồm OpenAI, DeepMind của Google, Anthropic và Microsoft, tạo được sự chú ý trên toàn cầu.

Việc OpenAI phát hành ChatGPT vào tháng 11 năm ngoái đã tạo ra một cơn sốt thực sự, khi nó chứng tỏ khả năng của các mô hình ngôn ngữ lớn, công nghệ cơ bản đằng sau chatbot, trong việc tạo ra những văn bản thuyết phục, có thể viết được một bài luận hoàn chỉnh hoặc cải thiện nội dung email.

Nó cũng đã tạo ra một cuộc chạy đua giữa các công ty trong lĩnh vực này để tung ra các công cụ AI tổng hợp của riêng họ, để người dùng có thể tạo ra văn bản và hình ảnh đầy chân thực.

Nhưng đó cũng chính là mối nguy hiểm của AI: khả năng tạo ra và truyền bá thông tin sai lệch, chi phối các cuộc bầu cử trên khắp thế giới; khả năng thay thế hoặc chuyển đổi công việc của con người, đặc biệt là trong các ngành công nghiệp sáng tạo…

Tháng 7 vừa qua, Tổ chức Hợp tác và Phát triển Kinh tế (OECD) đã cảnh báo rằng những ngành nghề có nguy cơ bị AI thay thế cao nhất sẽ là những công việc lao động trí óc, tay nghề cao, hiện chiếm khoảng 27% việc làm trên khắp các nền kinh tế thành viên. Báo cáo của tổ chức này nhấn mạnh “nhu cầu khẩn cấp phải hành động” và phối hợp ứng phó để “tránh một cuộc chạy đua xuống dốc”.

Trên thực tế, các cơ quan quản lý và các công ty công nghệ đã lớn tiếng bày tỏ sự cần thiết phải kiểm soát AI, nhưng ý tưởng về cách quản lý các mô hình và người tạo ra chúng có sự khác biệt lớn tùy theo khu vực. Đáng chú ý, Liên minh châu Âu (EU) là nơi đầu tiên trang bị cho mình Đạo luật AI - dự kiến sẽ được chính thức thông qua vào cuối năm nay.

EU đã soạn thảo các biện pháp cứng rắn đối với việc sử dụng AI nhằm đặt trách nhiệm lên các công ty công nghệ để bảo đảm mô hình của họ không vi phạm các quy tắc. Động thái này có thể được coi là một nỗ lực nhằm thiết lập khuôn mẫu cho các quốc gia khác noi theo, theo phong cách của Quy định bảo vệ dữ liệu chung của châu Âu (GDPR), vốn đã cung cấp khuôn khổ cho luật bảo vệ dữ liệu trên toàn thế giới.

EU được cho đã hành động nhanh hơn nhiều so với Mỹ - nơi các nhà lập pháp cũng đang chuẩn bị đánh giá rộng rãi về AI, để trước tiên là xác định những yếu tố nào của công nghệ có thể phải tuân theo quy định mới và những gì có thể được điều chỉnh bởi luật hiện hành.

Trong khi đó, Vương quốc Anh đang cố gắng sử dụng vị trí mới của mình bên ngoài EU để tạo ra cơ chế linh hoạt hơn của riêng mình, nhằm điều chỉnh các ứng dụng AI theo ngành thay vì theo phần mềm làm nền tảng cho chúng.

Cả hai cách tiếp cận của Mỹ và Anh đều được cho là sẽ ủng hộ ngành AI hơn luật của Brussels - vốn đã bị giới công nghệ chỉ trích gay gắt.

Tuy nhiên, những hạn chế nghiêm ngặt nhất đối với những người sáng tạo AI được tin có thể lại đến từ Trung Quốc, khi nước này đang tìm cách cân bằng các mục tiêu giữa việc kiểm soát thông tin được phân chia bởi các mô hình tổng hợp và sự cạnh tranh trong cuộc đua công nghệ với Mỹ.

Luật pháp chặt chẽ cần sự thống nhất

Bất chấp những lo ngại về luật pháp ở châu Âu, nhiều người tin rằng những công ty lớn nhất trong ngành AI đang đặc biệt quan tâm đến những gì mà các siêu cường đối thủ của thế giới đang làm.

Dame Wendy Hall, đồng Chủ tịch cuộc đánh giá AI của Chính phủ Anh năm 2017 và là giáo sư khoa học máy tính tại Đại học Southampton, nhận định: “Dù là EU hay Vương quốc Anh cũng đều không có quyền kiểm soát những công ty AI, trừ khi các công ty muốn làm ăn ở châu Âu. Nhưng có một sự phụ thuộc rõ ràng vào những gì Chính phủ Trung Quốc hoặc Mỹ đang làm trong việc quản lý các công ty công nghệ nói chung”.

Trung Quốc đã đưa ra các quy định có mục tiêu cho nhiều công nghệ mới khác nhau, bao gồm các thuật toán đề xuất và AI tổng hợp, đồng thời cũng đang chuẩn bị soạn thảo luật AI quốc gia mở rộng hơn trong những năm tới. Ưu tiên của Bắc Kinh được cho là kiểm soát thông tin thông qua quy định về AI, trong đó yêu cầu tuân thủ “các giá trị cốt lõi của chủ nghĩa xã hội”.

Cùng với đó, các nhà cung cấp AI sáng tạo có sản phẩm có thể “tác động đến dư luận” tại Trung Quốc phải nộp đơn để đánh giá bảo mật - theo quy định có hiệu lực kể từ tháng 8/2023. Một số “gã khổng lồ” công nghệ Trung Quốc, bao gồm Baidu và ByteDance, đã nhận được sự chấp thuận và đã phát hành các sản phẩm AI của họ ra công chúng hồi cuối tháng 8.

Những hạn chế như vậy cũng sẽ áp dụng cho các công ty nước ngoài, khiến việc cung cấp dịch vụ AI sáng tạo nội dung cho người dùng ở Trung Quốc trở nên ngày một khó khăn.

Trong khi đó, Mỹ cho đến nay vẫn để ngành AI tự điều chỉnh, với việc Microsoft, OpenAI, Google, Amazon và Meta ký một loạt cam kết tự nguyện tại Nhà Trắng hồi tháng 7. Các cam kết bao gồm thử nghiệm nội bộ và bên ngoài các hệ thống AI trước khi chúng được tung ra với công chúng, giúp mọi người xác định nội dung do AI tạo ra, tăng tính minh bạch về khả năng cũng như hạn chế của hệ thống.

Chính quyền Tổng thống Joe Biden cho biết họ đang soạn thảo một lệnh hành pháp nhằm thúc đẩy “sự đổi mới có trách nhiệm”, nhưng không rõ khi nào nó sẽ được ký kết và những biện pháp nào sẽ được đưa ra. Tuy nhiên, lệnh được cho có thể sẽ tập trung nhiều vào việc hạn chế khả năng mua các chương trình AI của Trung Quốc, cũng như việc thiết lập các rào chắn cho các công ty Mỹ.

Nhìn chung, những cách tiếp cận cực kỳ khác nhau này trên toàn cầu được cho có nguy cơ khiến ngành AI rơi vào tình trạng quan liêu hơn. Thực tế, mọi chính quyền bản địa phải có sự liên kết với các quốc gia khác để công nghệ - vốn không bị giới hạn bởi biên giới - có thể được kiểm soát một cách chặt chẽ.

Vào tháng 5, các nhà lãnh đạo của các quốc gia G7 đã ủy nhiệm một nhóm làm việc nhằm hài hòa các cơ chế quản lý, được gọi là Quy trình AI của Hiroshima. Sáng kiến này nhằm bảo đảm luật pháp có thể tương tác giữa các nước thành viên. Hay việc Vương quốc Anh dự kiến sẽ tổ chức Hội nghị Thượng đỉnh AI toàn cầu vào tháng 11 năm nay để thảo luận về cách thức phối hợp quốc tế về quy định có thể giảm thiểu rủi ro.

Giáo sư David Leslie của Viện Alan Turing - Viện quốc gia về khoa học dữ liệu và AI của Vương quốc Anh, bình luận: “Chúng ta đang ở thời điểm mà quy định là điều bắt buộc phải có. Và ở đây cần phải có hành động quốc tế phối hợp hơn, vì hậu quả mà việc phát triển AI một cách vô pháp có thể tạo ra không còn là vấn đề quốc gia, mà sẽ mang tính toàn cầu”.

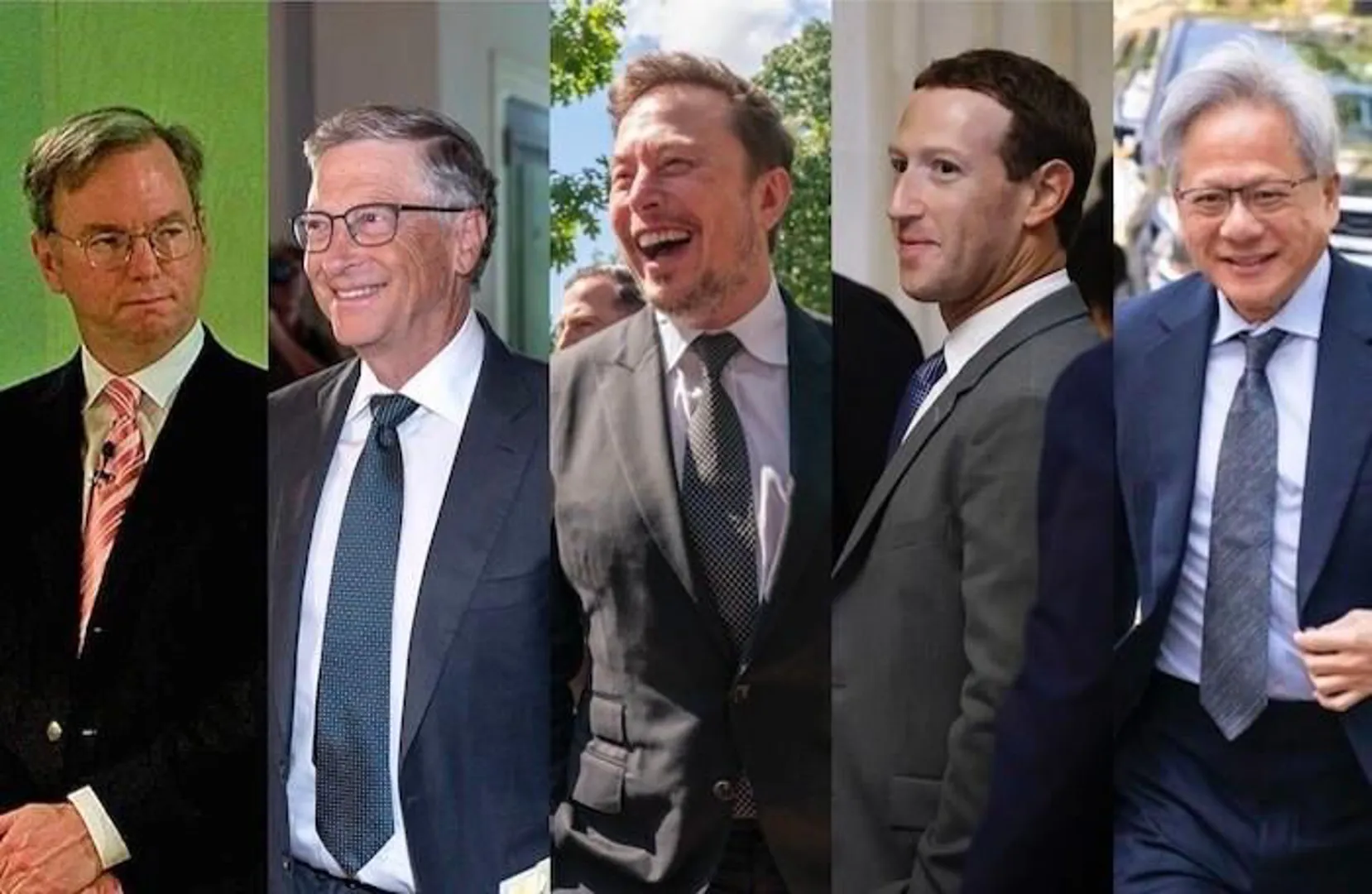

Tỷ phú công nghệ Mỹ bàn về quản lý AI

Kinhtedothi - Ngày 13/9, Hội nghị AI của Thượng viện Mỹ đã diễn ra trong một căn phòng khép kín tại Đồi Capitol, Washington với sự góp mặt của những tỉ phú công nghệ hàng đầu.

4 lý do khiến nhiều tập đoàn hạn chế sử dụng ChatGPT

Kinhtedothi- Trong khi nhiều tập đoàn đang nghiên cứu ứng dụng ChatGPT thì Apple, Spotify, Samsung, Amazon, Bank of America và nhiều công ty đa quốc gia khác lại hạn chế tích hợp AI vào quy trình làm việc vì những lo ngại về quyền riêng tư đối với việc cung cấp dữ liệu bí mật về công nghệ.

“Cha đẻ” ChatGPT ra mắt tiền điện tử Worldcoin

Kinhtedothi - Đồng Worldcoin sẽ chính thức được niêm yết trên sàn giao dịch tiền điện tử lớn nhất thế giới Binanace, với thời gian mở giao dịch dự kiến bắt đầu từ 4h chiều nay (theo giờ Việt Nam).