Theo Nvidia, sự ra đời của H200 sẽ tạo ra những bước nhảy vọt về hiệu suất. Dự kiến, Nvidia H200 sẽ được dùng trong các siêu máy tính hoặc đào tạo AI với khả năng cho ra kết quả nhanh gấp đôi H100 hiện nay (đã thử nghiệm với mô hình ngôn ngữ lớn Llama 2 của Meta với 70 tỷ tham số). Như vậy, H200 sẽ là chip AI thuộc top mạnh hàng đầu hiện nay.

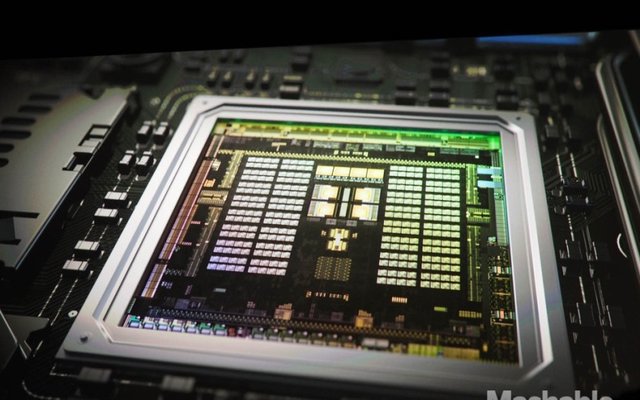

Mặc dù chưa có nhiều thông tin về dòng GPU mới nhưng có thông tin rằng dung lượng bộ nhớ và băng thông đã được cải tiến. Cụ thể: Sản phẩm vẫn được xây dựng trên kiến trúc Hopper giống bản tiền nhiệm. Tuy nhiên, H200 sử dụng bộ nhớ HBM3e dung lượng 141 GB, băng thông 4,8 TB/s.

H200 cũng sẽ tương thích với các hệ thống H100 trước đây nhằm giúp các hệ thống hiện tại có thể dễ dàng nâng cấp.

Với cấu hình sử dụng tám GPU, khả năng tính toán 32 petaflop (triệu tỷ phép tính mỗi giây), H200 sẽ cải thiện khả năng làm việc của các hệ thống AI tạo sinh cũng như các hệ thống điện toán hiệu năng cao (HPC) đồng thời giúp giải quyết một số thách thức quan trọng nhất với thế giới.

Khi sản phẩm được ra mắt, Amazon Web Services, Google Cloud, Microsoft Azure và Oracle sẽ là những nền tảng điện toán đám mây đầu tiên trang bị H200.

Hiện chưa có giá chính thức của H200, nhưng mẫu chip tiền nhiệm H100 hiện nay được các công ty AI săn lùng ở mức giá 25.000-40.000 USD.